nueva NPU con 32 Cores para iOS 18 y su IA

Apple es el último gigante en llegar a la IA. Ya lo dijo Tim Cook hace tiempo, que no haría llegar a su compañía de una manera vaga a la era de la Inteligencia Artificial, y que cuando tuviesen algo realmente interesante, entonces lo lanzarían. El momento llegará a finales de este año, y como era de esperar, el iPhone 16 y su nueva NPU para IA serán los protagonistas. Una filtración revela algunos datos más sobre lo que ya tiene preparado los de la manzana mordida, y realmente pinta bien.

Desde Taiwán, la información no se ha hecho esperar, y es que al parecer en la isla tienen todo lo que se necesita saber para lanzar afirmaciones varias. En este caso, no solamente hacen referencia al SoC para smartphones, sino también al SoC que llegará para portátiles, lo cual es realmente interesante.

iPhone 16 con SoC A18 Pro, una NPU que aumentará sus núcleos significativamente para IA

La información que llega desde la isla apunta a una afirmación y un rumor al mismo tiempo. Sabemos que las NPU actuales que Apple tiene en el mercado no dan en TOPS como para tener lo que Tim Cook quiere: IA en dispositivo.

Es decir, que todo se quede a nivel local y no se tenga que externalizar servicios a la nube, como hace Google por ejemplo. La excusa es la privacidad (como si la hubiera en cualquier teléfono actual), la solución llega, lógicamente, desde la NPU.

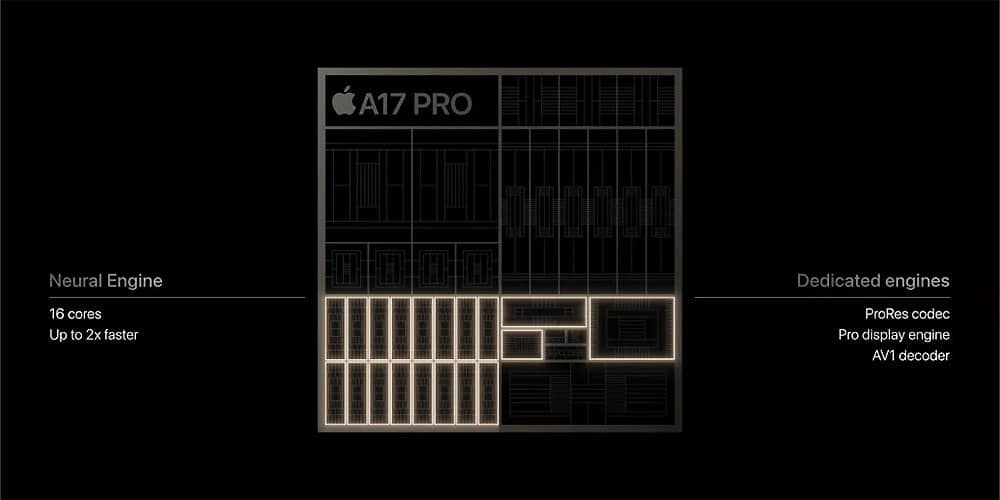

Actualmente en los smartphones de la manzana mordida tenemos 16 Cores en su Neural Engine (NPU), y aunque su potencia ha aumentado, su número de cores lo arrastramos desde el iPhone 12. Por ello, la información asegura que Apple ha introducido una versión muy mejorada de su Neural Engine, donde el número de núcleos aumentará “significativamente”.

Y claro, las comillas aquí es lo realmente determinante, porque no se ofrece un número en concreto, pero ahí llega el siguiente rumor.

Hasta 32 Cores en smartphone y puede que ¿64 en portátiles?

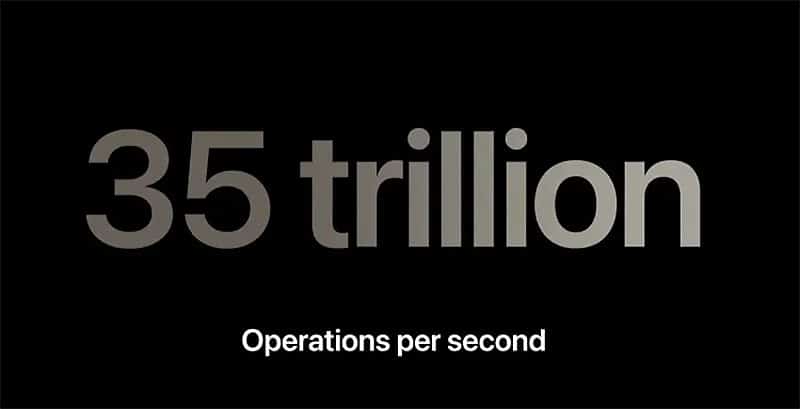

Ese es el rumor. El iPhone 16 tendrá en su configuración más alta para el A18 Pro hasta 32 Cores en su NPU para IA, lo cual implicará, como poco, duplicar el rendimiento en TOPS del actual iPhone 15 Pro Max (35 TOPS).

Por ello, debemos esperar un rendimiento impresionante de más de 70 TOPS. Para que nos hagamos una idea, AMD con los Ryzen 8040 Hawk Point anuncia 16 TOPS para su Ryzen AI (NPU), donde si sumamos CPU y GPU el número total asciende a 39 TOPS. Intel ahora mismo con Meteor Lake ofrece 10 TOPS en su NPU y 34 en total sumando procesador y gráfica, pero con Lunar Lake, su sucesor en portátiles, ya han afirmado públicamente que multiplicarán el rendimiento por tres.

O lo que es igual, 30 TOPS puros para la NPU y seguramente casi 100 TOPS si sumamos CPU + GPU. El problema es que no sabemos si Apple cuenta solamente el rendimiento de su NPU o suma el resto para dar los valores.

La controversia con los TOPS

De hecho, hay contradicciones en los Data Sheet de Apple en cuanto a su Neural Engine:

Al entrenar modelos de aprendizaje automático, los desarrolladores se benefician del entrenamiento acelerado en GPU con PyTorch y TensorFlow al aprovechar el backend de Metal Performance Shaders (MPS). Para implementar modelos entrenados en dispositivos Apple, utilizan coremltools , la herramienta de conversión unificada de código abierto de Apple, para convertir sus modelos favoritos de PyTorch y TensorFlow al formato de paquete de modelos Core ML.

Luego, Core ML combina a la perfección CPU, GPU y ANE (Apple Neural Engine) (si está disponible) para crear el plan de ejecución híbrido más eficaz que explota todos los motores disponibles en un dispositivo determinado. Permite que una amplia gama de implementaciones de la misma arquitectura modelo se beneficien del ANE incluso si toda la ejecución no puede realizarse allí debido a las idiosincrasias de diferentes implementaciones.

Este flujo de trabajo está diseñado para facilitar a los desarrolladores la implementación de modelos en dispositivos Apple sin tener que preocuparse por las capacidades de ningún dispositivo o implementación en particular.

Aunque la flexibilidad de implementación que ofrece la ejecución híbrida es simple y poderosa, podemos intercambiar esta flexibilidad a favor de una implementación particular y basada en principios que aproveche deliberadamente el ANE, lo que resulta en un rendimiento significativamente mayor y un consumo de memoria reducido.

Otros beneficios incluyen mitigar la sobrecarga de transferencia de contexto entre motores y abrir la CPU y la GPU para ejecutar cargas de trabajo que no sean de ML mientras ANE ejecuta las cargas de trabajo de ML más exigentes.

Apple sumaría todos los rendimientos en el iPhone 16 para hacer su juego de marketing con la NPU para IA

Lo que da a entender es que con Core ML se usa CPU+GPU+NPU, pero que en casos particulares para mitigar la sobrecarga de transferencias entre motores se puede hacer que CPU y GPU hagan tareas comunes y ANE las tareas de ML.

Por tanto, debemos de entender según lo escrito que Apple suma CPU+GPU+NPU cuando da la potencia en TOPS. Para terminar, si Apple duplica los Cores en su NPU daría un salto de gigante en el rendimiento y deja entrever la dificultad que tendrá iOS 18 en cuanto a la IA que incluirá y lo ambicioso del proyecto.

El problema es que el nodo de TSMC disponible no tendrá una reducción del área suficiente como para impedir que el tamaño final del SoC sea mayor, y eso implicará también que el A18 Pro deba ser más caro. La solución podría ser segmentar la NPU en distintos números de núcleos, dejando esos supuestos 32 Cores para el iPhone 16 Pro Max, por ejemplo.